Was ist Edge AI?

In letzter Zeit wird viel über die sogenannte Edge AI gesprochen. Hier wird die Zukunft der künstlichen Intelligenz gesehen. Deshalb haben wir uns entschieden, dieses Prinzip genauer zu erklären und die neuesten – auf dem Markt verfügbaren – Technologien darzustellen.

In diesem Artikel erfahren Sie:

- Wo liegt der Vorteil von Edge AI?

- Wie ist ihre Anwendung?

- Beispiele für die neusten Geräte in diesem Bereich (einschließlich Google Coral und Nvidia Jetson)

Was ist Edge AI?

Edge AI ist eine Anwendung, deren Algorithmen der künstlichen Intelligenz direkt auf dem Gerät, auf der Hardware installiert sind und die Daten direkt gesammelt werden. Das kann beispielsweise eine Drohne, eine Kamera oder eine Augmented-Reality-Brille sein. So entfällt der Datentransfer zu einem Server oder einer Cloud, wie es bei klassischen Methoden ist.

Anwendung von Edge AI

Die Umstellung des Datenverarbeitungsortes auf ein Endgerät ist dann besonders wichtig, wenn:

- Die Geschwindigkeit der Datenverarbeitung von entscheidender Bedeutung ist, dass sogar kürzeste Verzögerung von Millisekunden unerwünscht bis gefährlich sind.

- Es Probleme mit einem stabilen Zugriff auf das Netzwerk gibt. Eine solche Situation kann z.B. in dünn besiedelten Regionen oder in Räumen auftreten, die das Signal bewusst blockieren.

- Es sehr sensiblen Daten sind, die das Gerät nicht verlassen dürfen.

- Der Stromverbrauch niedrig sein muss. Wir müssen nicht ständig Daten in die Cloud senden, so dass der Einsatz von Batterien automatisch minimiert wird.

Die Anwendungsmöglichkeiten von Edge AI sind sehr vielfältig.

Dazu gehören autonome Fahrzeuge und Drohnen. Das gemeinsame Merkmal ist die Notwendigkeit, Entscheidungen in Echtzeit zu treffen. Daher bleibt keine Zeit, Daten zur Weiterverarbeitung in die Cloud zu senden.

Die Edge AI wird auch in Wearables eingesetzt. Intelligente Uhren und Armbänder erfassen immer genauere Messungen der Vitalwerte. Diese Informationen, kombiniert mit Algorithmen der künstlichen Intelligenz, ermöglichen die Planung von Training, Gesundheitsversorgung und Altenpflege.

Edge AI trägt auch dazu bei, die Vorgaben von Industry 4.0 umzusetzen und ermöglicht unter anderem eine schnelle Erkennung zukünftiger Maschinenfehler auf der Grundlage von Sensormessdaten, die unter anderem Vibrationen, Temperatur und Ultraschall untersuchen. Es unterstützt auch die allmähliche Automatisierung des Produktionsprozesses und der Qualitätskontrolle. In diesem Fall werden Bildverarbeitungsalgorithmen zum Erkennen, Klassifizieren und Verfolgen von Objekten in der unmittelbaren Umfeld der Anlage eingesetzt.

Es gibt unzählig viele solcher Beispiele. Dazu gehören alle Bereiche und Situationen, bei denen die oben genannten Gründe relevant sind. Denken Sie nur an Smart Homes, Smartphones, Augmented Reality-Brillen…. Und das ist erst der Anfang, denn diese Technologien kommen immer mehr in unser tägliches Leben und Business.

Technologien, die Edge AI unterstützen

Der Edge AI-Markt entwickelt sich sehr dynamisch. In letzter Zeit kommen immer mehr Endgeräte auf den Markt, auf denen tiefe neuronale Netze direkt laufen können.

Viele von ihnen sind einer Art AI-Beschleuniger, die über USB mit dem Gerät verbunden sind, oder in Form von ganzen Platten, an die Kameras und zusätzliche Sensoren angeschlossen werden können.

In diesem Artikel wollen wir jedoch auf die Möglichkeiten von zwei besonders interessanten Lösungen aufmerksam machen:

- soeben auf dem Markt erschienen Google Coral Beta

- und der Nvidia Jetson-Serie, insbesondere im Hinblick auf die Nvidia GTC 2019 Konferenz Jetson Nano

Edge AI in der Praxis - Google Coral

Wir haben vor kurzem die neueste Lösung von Google im Bereich der Edge AI – Google Coral getestet.

Es ist das erste TPU (Tensor Processing Unit) Gerät. Es verwendet die von Google entwickelte Technologie, die maschinelle Lernalgorithmen mit Hilfe einer speziellen integrierten Schaltung unterstützt. Für unsere Testversuche haben wir einen “AI zu USB”-Beschleuniger verwendet, den wir an das Raspberry 3 Board angeschlossen haben.

Es ist im Folgenden dargestellt:

Google Coral während des Testversuches mit Raspberry Pi3 und einer angeschlossenen Kamera.

Coral Beta (diese Version wurde diesen Monat veröffentlicht) konzentriert sich auf Bildverarbeitungsszenarien. Es ermöglicht die Erstellung von Lösungen zur Erkennung und Klassifizierung von Objekten in Bildern und Aufnahmen von der Kamera, beispielsweise Erkennung von Gesichter, Vogelarten oder Tausende von Alltagsgegenständen. In Google Coral können Sie mit Tensorflow Lite Modellen arbeiten. Es ist jedoch notwendig, es richtig zu kombinieren, damit es die Edge TPU-Technologie nutzen kann. Derzeit kann der Compiler mit vier Arten von neuronalen Netzwerkarchitekturen arbeiten:

- Inception V3/V4: 299×299 fixed input size,

- Inception V1/V2: 224×224 fixed input size,

- MobileNet SSD V1/V2: 320×320 max input size; 1.0 max depth multiplier,

- Oraz MobileNet V1/V2: 224×224 max input size; 1.0 max depth multiplier.

Die .tflite-Modelle sollten jedoch 100 MB nicht überschreiten.

Ein wesentlicher Vorteil der mit dem Edge TPU ausgestatteten TPU-API für Python ist die Möglichkeit, Transfer Learning zu nutzen, d.h. ein gelerntes Modell zu verwenden und es auf Ihren Daten zu trainieren. Dies kann direkt am Gerät erfolgen. Aufgrund der großen Datenmengen (Bildern) und langer Verarbeitungszeit war es besser, das Transfer Learning- Modell in unserem Fall am Computer zu ignorieren und es auf das Gerät zu verschieben.

Nvidia Jetson

Grafikkarten werden üblicherweise verwendet, um Deep-Learning-Modelle zu trainieren. Deshalb hat sich Nvidia entschlossen, seine langjährige Führungsrolle in diesem Bereich zu nutzen und in den Markt der Künstlichen Intelligenz einzusteigen.

Das Unternehmen spielt mit seiner Jetson-Produktlinie eine bedeutende Rolle im KI-Edge-Markt. Die Jetson-Produktlinie wird häufig in der Robotik und Drohnenindustrie eingesetzt. Die Serie mit Modellen wie dem TX2 oder der neuesten Version des AGX Xavier bietet hervorragende technische Parameter, die es ermöglichen, selbst sehr rechenintensive Algorithmen direkt auf dem Gerät auszuführen.

GTC Nvidia stellte auf der Konferenz letzte Woche auch Jetson Nano, ein neues Mitglied der Jetson-Familie, vor. Es ist viel kleiner und billiger als die anderen Produkte der Serie und bietet gleichzeitig beeindruckende technische Parameter. Es soll auch die Verwendung einer Vielzahl von neuronalen Netzwerkarchitekturen und bekannten maschinellen Lernframeworks wie TensorFlow, PyTorch, Keras, Caffe ermöglichen.

Eine interessante Ergänzung wird auch sein, dass CUDA-X-Bibliotheken für die Jetson-Serie verwendet werden können, die das vollen Nutzungs-Potenzial der GPU eröffnen.

Wir freuen uns darauf, Jetson Nano zu testen, um zu sehen, ob es mit fortgeschrittenen Anwendungen wie Bildsegmentierung und “Haltungsschätzung “umgehen kann.

Nvidia Jetson Nano versus Google Coral - Vergleich der Leistungsfähigkeiten

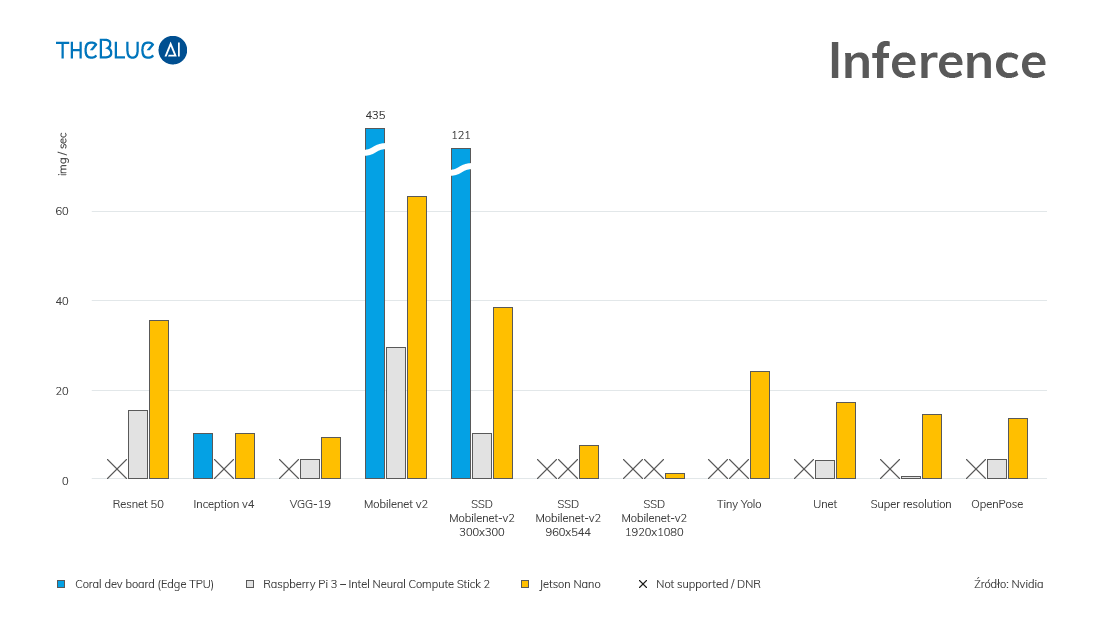

Nvidia legt mit Jetson Nano eine interessanten Performance im Vergleich zu seinen Wettbewerbern an: Googles Coral und der Neuronale Compute Stick von Intel in Bezug auf die Videoverarbeitung.

Wie aus der folgenden Grafik ersichtlich ist, erzielt Coral bessere Ergebnisse für die MobileNet-Architektur, aber Jetson Nano bietet eine viel breitere Palette an verfügbaren Netzwerkarchitekturen und Frameworks.

Einen detaillierteren Vergleich finden Sie hier.