Analityka wideo - Nowe podejście

Wyobraź sobie świat, w którym kamery nie tylko widzą, ale także rozumieją. Świat, w którym każda sekunda wideo nie jest tylko rejestrowana, ale także analizowana i interpretowana. Jest to obszar analizy wideo, dziedzina, którą badamy z fascynacją. Od identyfikacji prostego gestu ręki po skomplikowane rozpoznawanie działań w czasie rzeczywistym, analiza wideo jest kluczem do głębszego zrozumienia naszego świata zdominowanego przez obrazy.

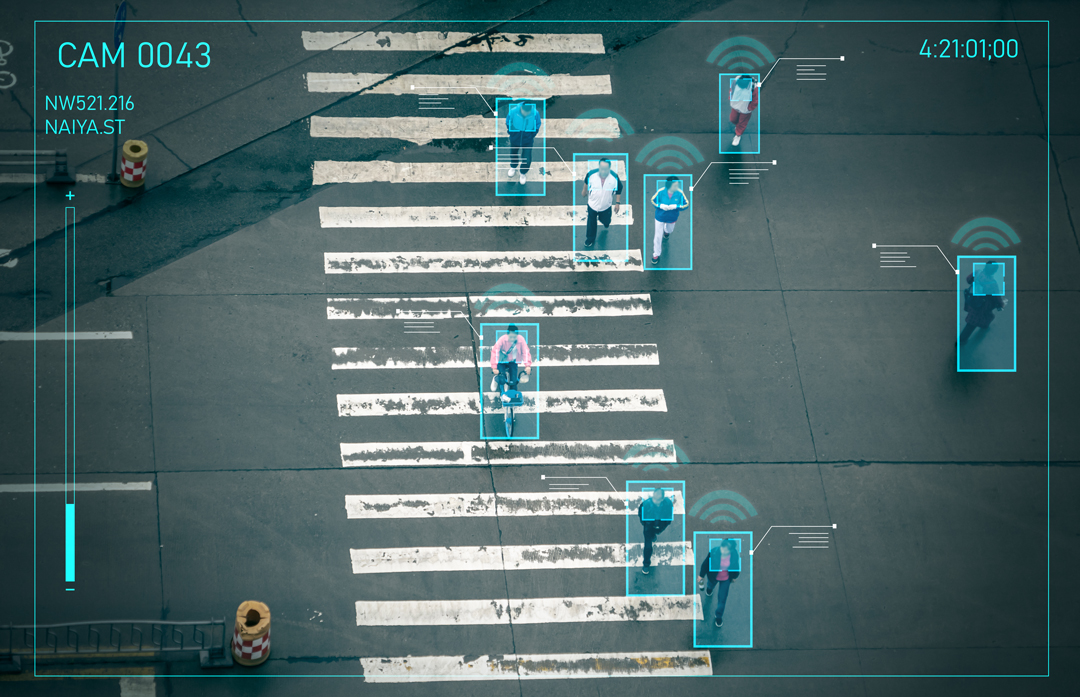

Dziedzina analizy wideo obejmuje szeroki zakres wyzwań i zadań. Może obejmować stosunkowo proste zadanie klasyfikacji działań, gdzie model przewiduje jaka aktywność jest prezentowana w danym wideo. Inne, bardziej skomplikowane zadania obejmują wykrywanie działań w czasie, które mają na celu przewidzenie znaczników czasowych konkretnych działań, oraz wykrywanie działań przestrzennych, skupiające się na lokalizacji wszystkich działań w wideo i oznaczaniu ich ramkami. Analityka wideo to więcej niż naukowe przedsięwzięcie; służy ona wielu rzeczywistym celom. Na przykład może być stosowana w sklepach bez kas, gdzie klienci mogą wziąć wszystko, czego potrzebują, a następnie po prostu opuścić sklep, ponieważ płatność za produkty dokonywana jest automatycznie. Innym zastosowaniem jest automatyczne rozpoznawanie tablic rejestracyjnych, które może zastąpić standardowe bilety na parkingach; w ten sposób cały proces może być przyspieszony na korzyść klientów.

Każde z wymienionych zadań stanowi inne wyzwanie, podkreślając obszerność tematu. Ta różnorodność pokazuje jej potencjał do służenia szerokiej gamie celów. W tym artykule jednak będziemy głównie rozważać klasyfikację działań, wykrywanie działań w czasie i wykrywanie działań przestrzennych jako całość podczas omawiania tematu analizy wideo. To zwężenie tematu pozwoli nam zagłębić się w zawiłości i zastosowania tych technologii w rozwijającym się świecie analityki wideo.

Nowe podejście

Po omówieniu wstępu, przejdziemy teraz do głównego tematu naszej dyskusji. Chcielibyśmy przedstawić Państwu nowe podejście w analizie wideo, które ściśle przypomina inne udane metody w różnych obszarach uczenia głębokiego. Dotyczy to fundamentalnego (foundation), samo nadzorującego się (self-supervised) modelu, który można łatwo dostosować do wielu zadań. Mowa o modelu VideoMAE v2, model ten należy do pierwszych w dziedzinie analizy wideo, który dąży do odgrywania roli podobnej do tego, co osiągnęła rodzina modeli GPT w dziedzinie przetwarzania języka naturalnego (NLP).

Zanim zagłębimy się w bardziej szczegółową analizę, zdefiniujmy, co rozumiemy przez model „fundamentaly” i „samo nadzorujący się”:

Model fundamentalny: Ten termin odnosi się do modeli, które mogą służyć wielu celom w danej dziedzinie bez większych zmian lub znaczącego dodatkowego szkolenia. Te modele są często szkolone na ogromnych ilościach danych i osiągają niejednokrotnie najlepsze wyniki w wielu subdomenach, porównywalne z bardziej wyspecjalizowanymi modelami zaprojektowanymi do pojedynczych zastosowań. Przykładem jest model ChatGPT w dziedzinie NLP, który może wykonywać zarówno tłumaczenie, jak i analizę sentymentu, nie będąc specjalnie szkolonym do żadnego z tych zadań.

Model samo nadzorujący się: Odnosi się to do modeli, które nie wymagają oznaczonych danych do szkolenia. Zamiast tego, model uczy się ogólnych cech prezentowanych danych. To podejście zmniejsza obciążenie związane ze zbieraniem ogromnej ilości oznaczonych danych, oszczędzając czas i pieniądze. Może to przynieść bardzo dobre wyniki, ponieważ pozyskiwanie nieoznaczonych danych jest znacznie łatwiejsze i tańsze, dlatego można dostać ich bardzo wiele.

Opis modelu

Zagłębmy się teraz w działanie modelu i zrozummy, jak osiąga swoje wyniki. Początkowo model przechodzi samo nadzorujące się wstępne szkolenie (pre-training), gdzie wykorzystuje ogromną kolekcję nieoznaczonych klipów wideo z różnych źródeł do nauki ogólnej reprezentacji wideo. Te źródła obejmują YouTube i Instagram, a także znane publiczne zbiory danych do analizy wideo, takie jak zestawy danych Kinetics i Something-Something. Wielkość i różnorodność zebranych danych są bezprecedensowe w dziedzinie wideo, z wykorzystaniem około 1,35 miliona klipów wideo z bardzo różnorodnych źródeł.

Proces wstępnego szkolenia ma na celu naukę ogólnych cech dostępnych danych. W tym celu autorzy używają metody Masked Auto Encoding w konfiguracji wideo (stąd MAE w VideoMAE). Metoda ta polega na początkowym enkodowaniu wideo za pomocą modelu Vision Transformer (ViT), jednocześnie stosując bardzo wysoki współczynnik maskowania w wysokości 90% – 95%. Oznacza to, że większość pikseli nie jest widoczna dla modelu, co stanowi bardziej znaczące i wymagające zadanie. Po procesie enkodowania, dekoder próbuje odtworzyć wideo na podstawie danych wyjściowych z enkodera. Wydajność sieci mierzona jest stratą średniego błędu kwadratowego pomiędzy znormalizowanymi maskowanymi pikselami, a odtworzonymi pikselami. Zasadniczo sieć stara się jak najdokładniej odtworzyć zakodowane wideo.

Po wstępnym szkoleniu autorzy sugerują, że aby uwolnić pełny potencjał modelu i uniknąć nadmiernego dopasowania do konkretnego zbioru danych podczas dostrajania, powinno być przeprowadzone nadzorowane dostrajanie po wstępnym szkoleniu (post-pre-training). Ten etap włącza semantykę różnych zbiorów danych do wstępnie wytrenowanego modelu. Zarówno etap po wstępnym szkoleniu, jak i faktyczne dostrajanie na konkretnym zbiorze danych wykorzystują tylko część enkodera sieci, czyli model ViT.

Wreszcie, po zakończeniu etapów wstępnego szkolenia i szkolenia po wstępnym szkoleniu, możemy dostrajać model na wybranym przez nas zbiorze danych. Dzięki wcześniejszym procesom, model teraz wymaga tylko drobnych dostosowań wag sieci, ponieważ już nauczył się ogólnych cech obecnych w danych wideo i bardziej specyficznej semantyki zadania z etapu po wstępnym szkoleniu. To podejście pozwala modelowi osiągnąć bardzo dobre wyniki w różnych testach z minimalnym dodatkowym dostrajaniem na jakimkolwiek konkretnym zbiorze danych.

Wnioski

Jak podkreśliliśmy, dziedzina analizy wideo obejmuje szeroki wachlarz wyzwań i zadań. Początkowo pozostawała w tyle za dziedzinami przetwarzania języka naturalnego (NLP) i analizy obrazu, głównie dlatego, że wymagała ogromnej ilości danych, które były trudniejsze do zdobycia, a cały proces szkolenia był bardziej skomplikowany w porównaniu do dziedziny obrazu. Jednakże, z nadejściem nowych podejść, takich jakie reprezentuje model VideoMAE v2, oraz coraz większych zbiorów danych, dziedzina ta szybko się rozwija. Wyniki modeli do analizy wideo są coraz bardziej obiecujące z każdym nowym modelem, co przekłada się na znaczący skok naprzód w możliwościach analizy wideo.

Skorzystaj z zaawansowanej analizy wideo dzięki spersonalizowanym rozwiązaniom AI od theBlue.ai

W theBlue.ai płynnie integrujemy naszą dogłębną wiedzę ekspercką w dziedzinie sztucznej inteligencji, którą używamy do tworzenia zaawansowanych rozwiązań do analizy wideo. Specjalizujemy się w tworzeniu spersonalizowanych systemów analizy wideo opartych na sztucznej inteligencji, które są precyzyjnie dostosowane do Państwa projektów i celów biznesowych. Skontaktuj się z nami, aby skutecznie przekształcić swoje pomysły w praktyczne zastosowania.